Senior DevOps-инженер

Инженер Linux

Самых востребованных навыков для системных администраторов и DevOps-инженеров

Средняя зарплата специалиста по направлению администрирование Linux

2014 вакансий на теорритории РФ

Из 1 миллиона лучших серверов

в мире работают на Linux

Cайтов с известными операционными системами используют Linux

Профессиональных разработчиков используют Linux в качестве платформы

в 2019 году

Разработчиков говорят, что Linux —

это платформа, на которой они

предпочитают работать

Из 500 лучших суперкомпьютеров

мира работают на Linux

Дополнили нашу программу 18 новыми

блокамидля того, чтобы вам было легче пройти сертификацию LPIC-2

Актуализировали информацию внутри

теоретических блоков и практик

Глубоко переработанные старые блоки

Вернем 20% поинтами если пройдете

весь практикум до конца за 4 месяца

Программа Linux Аdvanced подготовит вас

к сдаче экзамена и получению сертификации

LPIC-2 (Advanced Level Linux Professional)*

*Сертификация Linux Professional institute (LPIC) является

международным стандартом в области подтверждения

знаний по операционным системам Linux.

Команда Rebrain изучает какие из компетенций требуются на разных уровнях профессий, мы понимаем что нужно знать, чтобы прийдя

на собеседование или решая рабочую задачу чувствовать себя уверенно. После наших практикумов специалисты легко справляются

с реальными задачами и быстрее двигаются по карьерной лестнице.

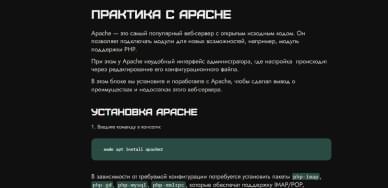

В каждой теме дается теория. Она состоит

из введения, основной части, небольших тестов, инструкции и summary. Каждая теоретическая часть заканчивается практическим заданием

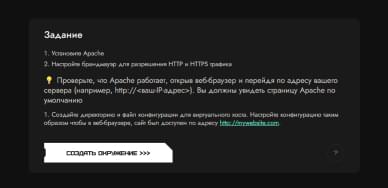

Для закрепления материалов из теоретической части дается задание, которое необходимо выполнить на реальном окружении. Это подготавливает вас к реальным рабочим задачам с конкретным инструментом

Поддержим вас на всех этапах обучения. У нас есть координаторы и менторы, которые всегда помогут,

а также закрытый чат со студентами практикума. А ваш ментор действующий специалист по IT-инфраструктуре

Пользователям, купившим Linux Advanced, будут доступны записи практикумов по теме вашего направления. На них вы сможете прокачать дополнительно свои навыки, а также узнаете лайфхаки, которые пригодятся в работе.

Вся практика проходит на удобной и современной LMS-платформе

Общайтесь с опытными коллегами, стройте networking, получайте свежие

эксклюзивные вакансии, обсуждайте рабочие кейсы, мотивируйтесь

на обучение, получайте анонсы наших бесплатных мероприятий

Кто-то хочет сменить работу и открыть для себя новые горизонты, кто-то — получить повышение. Александр не относит себя ни к тем, ни к другим. Он прошёл наш практикум linux advanced, чтобы быть во всеоружии на случай перехода компании на новое ПО, а ещё — чтобы закрепить уже имеющиеся знания и получить сертификат.

“Для своего развития продолжаю смотреть доступные после окончания программы вебинары, особенно по работе с сетями и Linux. Будущее я вижу за различными системами виртуализации: Docker, Kubernetes и так далее. Мне интересно то, что относится к DevOps, но со стороны администрирования: не писать что-то самому для Kubernetes, а поддерживать в рабочем состоянии то, что кто-то делает. В дальнейшем я бы хотел работать и развиваться в этой сфере.”

читать полностью >>>Сергей начал свой путь в IT в школьные годы, когда компьютеры начали массово появляться в домах. А интерес к технике привил отец-радиолюбитель: вместе с ним герой истории разбирал схемы и платы, паяльника тоже не боялся. Дальше на пути Сергея были вуз, армия и первая работа, в энергетике.

“Я считаю, что университетское образование даёт мало знаний, применимых в IT на данный момент. Технологии развиваются слишком быстро для бюрократической машины государственных ВУЗов, а преподаватели часто опираются на практику нулевых.

Но всё же я получил базовые навыки работы с контроллерами, датчиками, станками, которые пригодились мне в дальнейшем на первой работе. А ещё важнее — soft skills — в ВУЗе приобретаешь очень хорошие навыки общения, которые потом помогают при трудоустройстве.”

Участник наших практикумов по Linux Алексей знаком с компьютерами ещё с 90-х. Он работал с Miсrosoft до того, как это стало мейнстримом, а сейчас занимает должность ведущего инженера.

“Я выпустился из техникума по специальности «вычислительные машины: системы, комплексы и сети» в 1998 году. Это был год, когда в РФ произошёл дефолт. Специалист без навыков никому не был нужен. Я долго искал работу. За это время успел даже побыть менеджером. В 2004 году я понял, что мне не интересно заниматься закупками и продажами, и начал всё заново — уволился и пошёл работать рядовым сотрудником технической поддержки аптечной сети. Через 2 года понял, что нужно повышать уровень знаний и навыков, так как в учебном заведении дали минимум. ”

читать полностью >>>При использовании данного сайта, вы подтверждаете свое согласие на использование файлов cookie и других похожих технологий в соответствии с настоящим Уведомлением.